アップルによるPrimeSenseの買収、GoogleTangoプロジェクト、クアルコムなど3Dセンサリング技術特許など、今モバイルデバイスは、GPSやジャイロセンサーだけでなく、3次元空間をスキャンし、人間のように空間を認識しようとしているようです。この技術のコアは、3Dマッピング技術と、3Dセンサリングによるジェスチャー認識技術と言えます。「アップル、3Dジェスチャー制御チップ開発のイスライル企業を3億5千万ドルで買収か?」でも紹介しましたが、今GoogleのTangoプロジェクトをはじめ各社3Dセンサリング技術について水面下で凌ぎを削っているようです。

ここで主要企業の動きをまとめてみます。

アップル社のPrimeSense社買収:Microsoft社Xboxと連携するKinectにも使われている3DセンサリングチップPrimeSense社のチップをまずはアップルTVで応用しようとしているようです。ジェスチャーの認識にとどまらず、空間スキャンなどにも使えるチップで、今後モバイルデバイスに搭載すべく省電力化もおこなっているそうです。((techcrunchより))

PrimeSenseチップが組み込まれたセンサーによる空間スキャンのデモムービー

グーグルタンゴプロジェクト:タンゴプロジェクトのスマートフォンは他のスマートフォン同様にコンパスとジャイロが搭載されているが、Googleが開発した新センサーシステムは周囲をスキャンして

1.Kinectのように動作やジジェスチャーを認識する。

2.また周囲をスキャンし3D空間マップを生成する

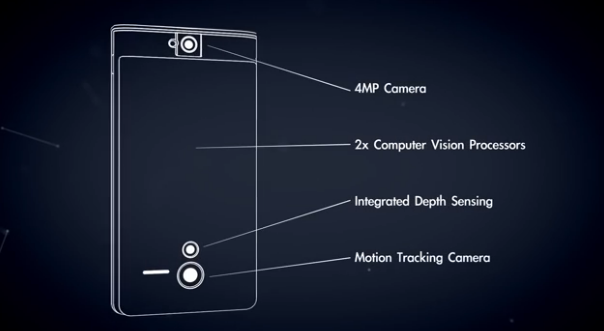

タンゴのシステムはLeap Motionのようなジェスチャー技術ベースのUIを開発するためのものではない。逆にスマートフォンが周囲の3D空間を認識し自分の位置が分かるようになった場合、デベロッパーがどのようなアプリを作り出せるかという点で可能性を探るようです。((techcrunchより))

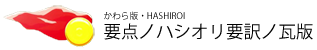

超省電力のMyriad1チップを搭載したTangoプロジェクトのコンセプトビデオ

4メガピクセルのカメラの画像解析により3次元座標化。震度センサーやモーションキャプチャーカメラの複合技により3次元空間中のモバイルデバイスの状態と対象のどの部分にモバイルデバイスを向けているか認識可能なようです。

例えばマイクロソフトのKinectに搭載されているPrimeSenseチップだと1ワットの電力を消費するそうです。一方iPhoneのバッテリーは1500mAh程度だそうなので、PrimeSenseのようなチップが消費される電力は問題外だったようです。

Myriad1は数百ミリワットで稼働する省電力チップでスマートフォンに乗せることが可能になったそうです。アップル社によるイスラエル企業PrimeSense社の買収についても技術的にそうであるように、モバイル上における三次元センサリング技術については、その消費電力の問題からまだ数年先のことだと誰もが思っていたようですが、数百マイクロワットで1GMHものプロセッシングが可能となるプロセッサーの出現で実用化へ向けて現実味を帯びてきたようです。そういう意味では、PrimeSsene社のチップは現在省電力化奮闘中ということで、GoogleTangoプロジェクトはアップルより先行して実フィールド実験にはいったという感じのようですね。

高機能チップの省電力化技術が進むことで、スマートフォン上でも3Dセンサリング技術が当たり前のように搭載される流れが次の世代の端末の流れだと各メーカーは考えているようです。アップルもグーグルもアマゾンもモバイル端末における3Dセンサリング技術については現在試行錯誤しているようです。

「3Dセンサリング技術」、「3Dマッピング・ビジュアルプロセッシング技術」、これにマッピングされた空間に識別タグなどが組み込まれるとどうなるか?ということですが、GoogleMapならず現実世界の完全なバーチャルデータ化が可能となるわけです。

もちろんサーバーサイドですが、スマートウォンやウェアラブルデバイスは、現実世界に存在するすべてのオブジェクトに対し、例えば、グーグル社が進めているナレッジグラフのような構造化されたデータと関連付けできるようになるわけです。

「西暦2028年。ビックデータカンパニーが全てを支配するデータ箱庭社会なっている!?」で紹介したように、もはやバーチャル空間と現実世界は完全にデータにより構造化されることで、端末で識別できるようになるのかもしれません。

も一つ忘れてならい技術が空間を認識できるということは、その空間に対して、レーザー照射等により光粒子を反射できるようなサーフェスをプロジェクションマッピングできるようにもなるのではないかということです。つまり、そのサーフェスにモニター替わりにさまざまな画像やインターフェースを照射し、ジェスチャー認識により操作ができるようになるかもしれません。

空間を認識し、空間にスクリーンをプロジェクションし、それを操作できる。端末が今どこにいて、利用者の視線がどこに向いているのか(興味を持っているのか)が分かるということで、サーバーサイドのビックデータとやりとりすることで、もはや疑似AI的なやいとりが端末やウェアラブルデバイスをとおしてできるようになるわけです。

NHKで電脳コイルというアニメーションがやっていましたが、そのようなデバイスが10年以内に当たり前のように使われる時代がくるのかもしれません。当サイトでもたびたび紹介してきましたが、そのようなデバイスのコンセプトビデオを以下に並べてみました。このようなデバイスやサービスを早く使えるようになるといいですね。

|||

サラリーマンでもできるインカムゲインのヒント

|||

サラリーマンでもできるインカムゲインのヒント

|||

2台目自動車保険契約の落とし穴!等級引き継ぎの難しさが保険料アップにつながる理由

|||

2台目自動車保険契約の落とし穴!等級引き継ぎの難しさが保険料アップにつながる理由

|||

トイレをタンクレスにリニューアル:TOTOアラウーノ

|||

トイレをタンクレスにリニューアル:TOTOアラウーノ

|||

電池残量・時間を気にせず会議ができるUSBヘッドホン・ヘッドセット

|||

電池残量・時間を気にせず会議ができるUSBヘッドホン・ヘッドセット

|||

機能性抜群なオシャレなビジネスリュック-TUMI alpha BRAVO

|||

機能性抜群なオシャレなビジネスリュック-TUMI alpha BRAVO

|||

WindowsとMacでOffice365 EnterpriseからOffice2019,Office2021への切り替...

|||

WindowsとMacでOffice365 EnterpriseからOffice2019,Office2021への切り替...

|||

EVの次はタイヤが変わる!? エアレスタイヤとは

|||

EVの次はタイヤが変わる!? エアレスタイヤとは

|||

w205 Cクラス ナビのモニターが突然つかなくなる

|||

w205 Cクラス ナビのモニターが突然つかなくなる

|||

W205 Cクラスのフロントキシキシ音

|||

W205 Cクラスのフロントキシキシ音

|||

MLクラス,W166-冷却水が徐々に減るようなら修理が必要

|||

MLクラス,W166-冷却水が徐々に減るようなら修理が必要

|||

chatGPT:質問する言語で微妙に変わる回答センスが面白い

|||

chatGPT:質問する言語で微妙に変わる回答センスが面白い

|||

今更ながら知らなかった:確定申告に源泉徴収票の添付が必要なくなった件

|||

今更ながら知らなかった:確定申告に源泉徴収票の添付が必要なくなった件

|||

走行中に冷却水確認メッセージが出たら(MLクラス,W166)

|||

走行中に冷却水確認メッセージが出たら(MLクラス,W166)

|||

Windows11にアップデートすべきタイミング

|||

Windows11にアップデートすべきタイミング

|||

Space-X Falcon起動から戻る再利用ロケットがカッコイイ

|||

Space-X Falcon起動から戻る再利用ロケットがカッコイイ

|||

無料が前提だったSNSサービスも景気後退ともにフリーミアム化が推進される

|||

無料が前提だったSNSサービスも景気後退ともにフリーミアム化が推進される

|||

欧州車SUV(W166-ML350)のブレーキローターとパッド:ヤナセで純正部品での交換費用

|||

欧州車SUV(W166-ML350)のブレーキローターとパッド:ヤナセで純正部品での交換費用

|||

macOC Venturaのステージマネージャーを使ってみた

|||

macOC Venturaのステージマネージャーを使ってみた

|||

電化が進んだ車のバッテリー電圧には要注意

|||

電化が進んだ車のバッテリー電圧には要注意

|||

登山・キャンプアウトドアと普段使いを兼用できる大人の腕時計

|||

登山・キャンプアウトドアと普段使いを兼用できる大人の腕時計

|||

将来、スターリンクのような小型衛星は遠心力を使って打ち上げらえるようになる!?

|||

将来、スターリンクのような小型衛星は遠心力を使って打ち上げらえるようになる!?

|||

タイヤの値段が2022年にかけてここまで値上がりしているとは思わなかった

|||

タイヤの値段が2022年にかけてここまで値上がりしているとは思わなかった

|||

デジタル化が進む家電製品は高級品になるつつある

|||

デジタル化が進む家電製品は高級品になるつつある

|||

四半世紀続いたITそしてDXバブルも終焉の時が来る

|||

四半世紀続いたITそしてDXバブルも終焉の時が来る

|||

高価な電動自転車でギアが効かなくなっても意外と修理は安価に済むことも

|||

高価な電動自転車でギアが効かなくなっても意外と修理は安価に済むことも

|||

震度ではない階級で表される長周期自身が高層階に及ぼす揺れは、思った以上に凄まじい!?

|||

震度ではない階級で表される長周期自身が高層階に及ぼす揺れは、思った以上に凄まじい!?

|||

新築戸建て購入後10年後以降に取り換えが必要となる意外な設備

|||

新築戸建て購入後10年後以降に取り換えが必要となる意外な設備

|||

なかなかうまらない月極駐車場スペースをコインパーキング化して安定収入を図る

|||

なかなかうまらない月極駐車場スペースをコインパーキング化して安定収入を図る

|||

月面基地を作って火星探査に備えようとしているALTEMIS(アルテミス)計画とは

|||

月面基地を作って火星探査に備えようとしているALTEMIS(アルテミス)計画とは

|||

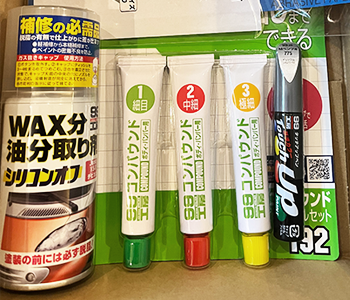

車の傷をDIYで直す:タッチペンとコンパウンドを使った応急補修

|||

車の傷をDIYで直す:タッチペンとコンパウンドを使った応急補修

過去の記事